-

PLUS

Krönika: Konsumentverket får städa när 2g och 3g stänger ner

-

PLUS

Krönika: Det här behöver Samsung göra för att lyckas 2026

-

PLUS

Så länge håller en mobil, snabbladdningens effekt och mer – Mobil svarar

-

PLUS

Krönika: Tre mobilhändelser som blir mina höjdpunkter 2026

-

PLUS

Mobil förutsäger mobilåret 2026 (del 1)

-

PLUS

Årets bästa produkter och viktigaste händelser – Mobil sammanfattar 2025

-

PLUS

Krönika: Okej, men hur agerar mobiloperatörerna i kaoset?

-

PLUS

Mobil svarar om telefonerna som blockeras i 2G- och 3G-nedstängningen

-

PLUS

PTS bär skulden när mobiler spärras med kort varsel

-

PLUS

Krönika: Bästa prylen jag någonsin köpt

Barnsäkerhet bortplockad

Apple lägger ner planerna på fotogranskning av Icloud-bilder

Apple skrinlägger planerna på fotogranskning för att hitta och varna om nakenbilder eller andra känsliga motiv.

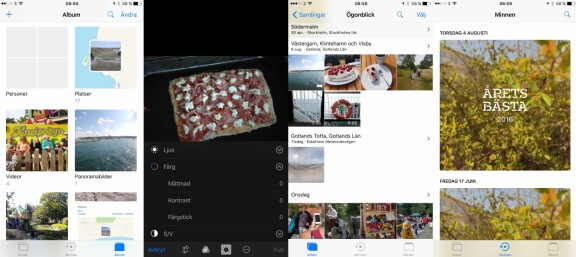

I augusti i år tillkännagav Apple att de tänkte introducera en funktion för att hitta det som kallas för CSAM, en förkortning för Child Sexual Abuse Material. Funktionen gick ut på att användares iCloud-bibliotek automatiskt skulle genomsökas efter bilder som föreställer sexuella övergrepp mot barn.

Funktionen möttes av massiv kritik där kritikerna hävdade att Apple skulle kunna tvingas av stater och andra mäktiga intressenter att använda funktionen för att leta efter bilder med annat innehåll än CSAM.

I september meddelade Apple att man hade för avsikt att skjuta upp introduktionen av funktionen. Nu verkar det som att företaget har lagt ner planerna på att lansera den då all relaterad information har plockats bort från företagets hemsidor.

Apple har även lanserat uppdateringen till Ios 15.2 där man introducerar funktionen för ökad barnsäkerhet, men även här lyser CSAM-funktionen med sin frånvaro.